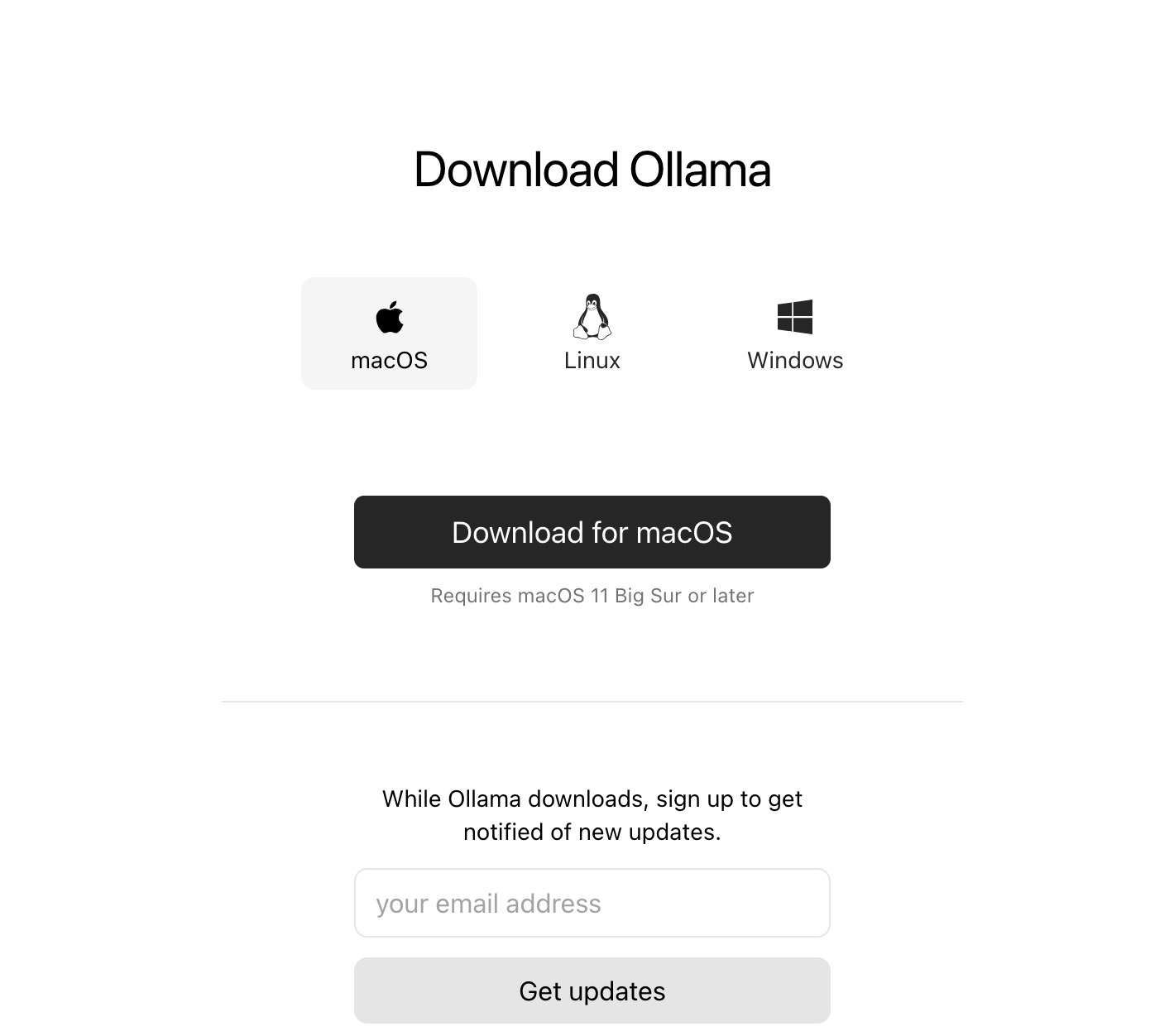

安装 Ollama

https://ollama.com/download

目前ollama只支持macOS和Linux, Windows平台。ollama。

要运行Llama2,只需在终端中执行命令 ollama run llama2 。执行此命令后,Llama2模型将被自动下载:

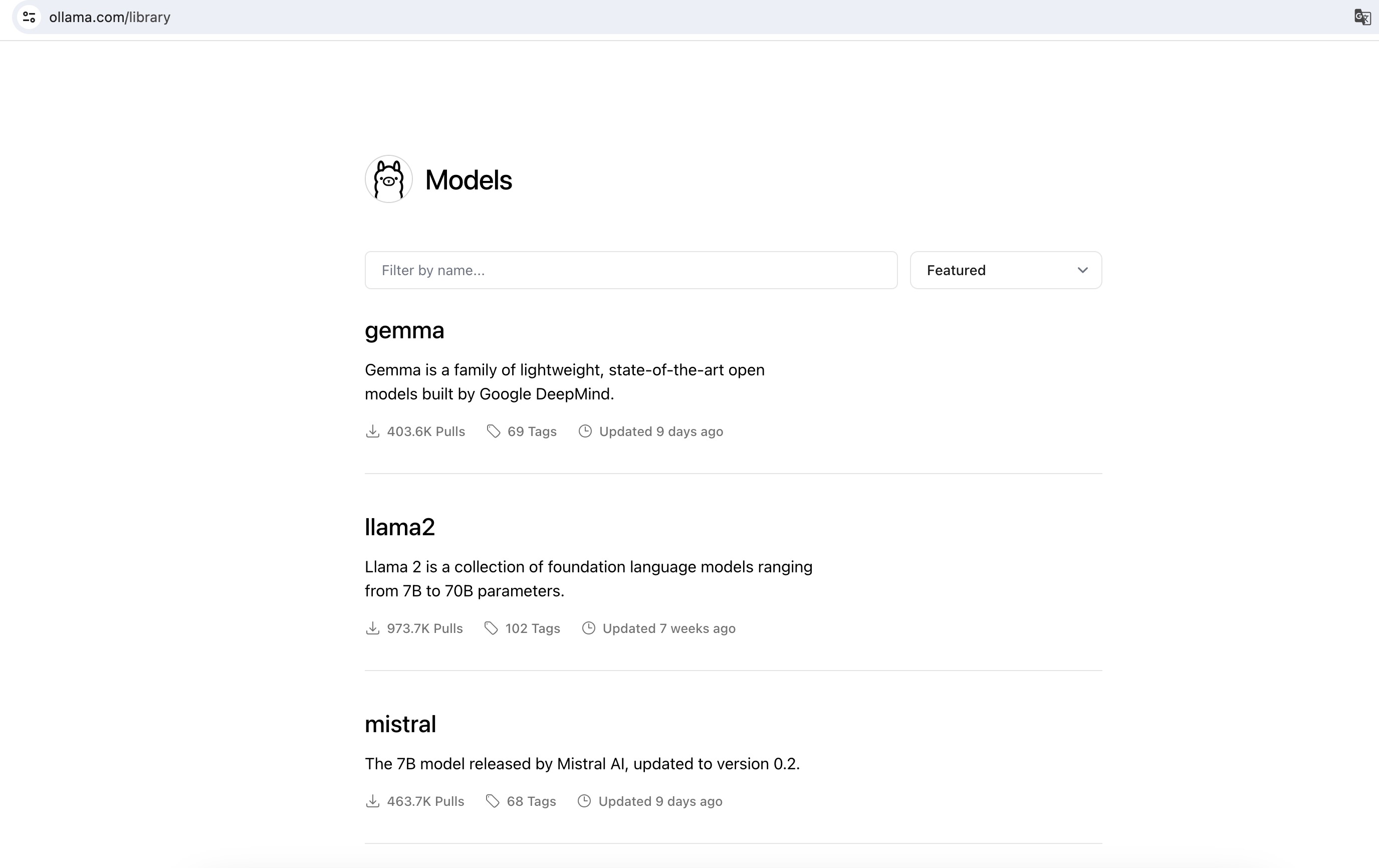

除了Llama2模型,Ollama还支持多种模型。您可以通过访问模型存储库来探索模型的全面列表。

模型库

https://ollama.com/library

注意:运行3B机型至少应该有8gb内存,运行7B机型至少应该有16gb内存,运行13B机型至少应该有32gb内存。

成功下载模型后,您可以与llama2模型进行交互:

如果不希望直接在终端中与大型语言模型交互,可以使用命令 ollama serve 启动本地服务器。一旦这个命令成功运行,你就可以通过REST API与本地语言模型进行交互: 启动本地服务器 ollama serve curl http://localhost:11434/api/generate -d '{ "model": "llama2", "prompt":"Why is the sky blue?"

}'

|