·“科技巨头的容错能力强,每一次科技领域的革命并不源于大公司犯错,而是源于一项新兴技术的快速崛起。老公司的退潮和新公司的崛起都是时代变化所致。在芯片领域,也许未来会出现适用于大模型的更专用的芯片,而带来这一革命的也许是一家没有历史包袱的新兴公司。”

在人工智能浪潮里掘金的“铲子”成了硬通货。

GPU(图形处理器)是发展人工智能的关键芯片, 科技巨头英伟达凭借其GPU在人工智能芯片市场一家独大,占据约80%的份额。

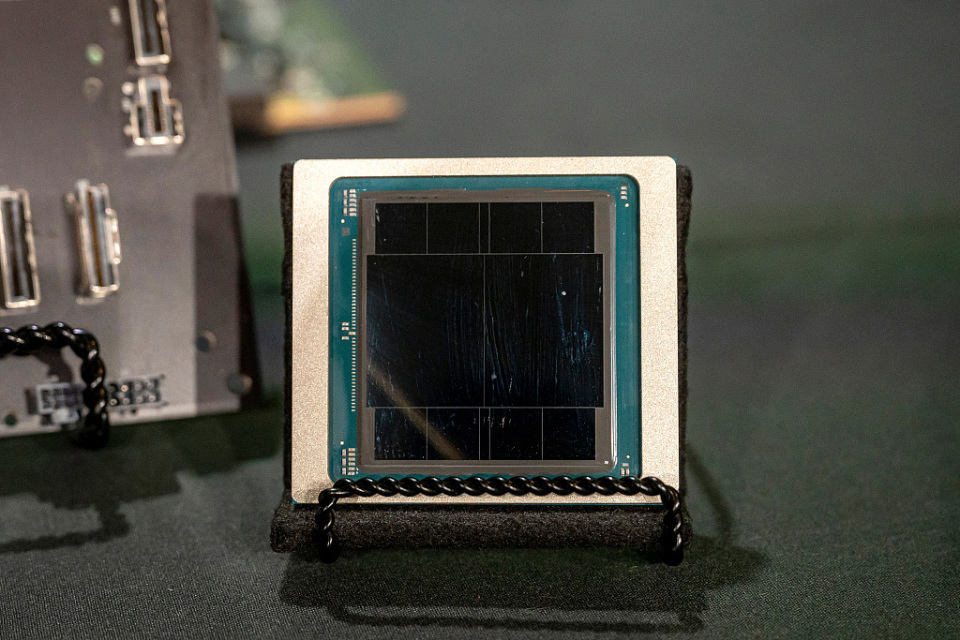

当地时间2024年3月19日,美国加州圣何塞,英伟达2024 GTC AI大会举行,正式推出名为Blackwell的新一代AI图形处理器(GPU)。视觉中国 资料图

AI芯片价格高昂,依然稀缺,Meta、谷歌、超威半导体(AMD)、英特尔、微软等科技巨头纷纷挑战英伟达的市场统治,推出对标产品。芯片大战愈演愈烈,谁是潜在颠覆者?

芯片大战愈演愈烈

H100芯片(英伟达于2022年公布的一款GPU芯片)供不应求,虽然英伟达今年3月又推出了H100的继任者——新一代人工智能芯片B200。但大大小小的企业都在寻求替代英伟达的GPU,试图破解AI芯片市场的一家独大的现状。

当地时间4月10日,Meta公布新一代Meta训练和推理加速器(MTIA)的计算和内存带宽是上一代解决方案的2倍多。最新版本芯片有助于驱动Meta在Facebook和Instagram上的排名和推荐广告模型。

就在前一天,英特尔也公布了人工智能芯片细节对抗英伟达。英特尔用于AI训练和推理的Gaudi 3加速器预计可大幅缩短70亿和130亿参数Llama2模型以及1750亿参数GPT-3模型的训练时间。英特尔表示,Gaudi 3芯片比英伟达H100训练特定大语言模型的速度快50%。

谷歌专用于训练生成式AI大模型的下一代加速器TPU v5p也通过谷歌云服务上线。微软首款人工智能芯片Maia 100预计今年上市。

去年12月,AMD推出了MI300人工智能加速器系列产品。其中MI300X拥有1530亿个晶体管,是适用于人工智能计算的高级GPU,专为大语言模型训练而设计,MI300A将图形处理功能与标准中央处理器(CPU)相结合,面向人工智能和科学研究。AMD表示,其MI300人工智能加速器正成为其历史上营收增长最快的产品,称其MI300X芯片的推理性能优于英伟达H100。

“谷歌的TPU已经迭代到了第五代,展现出了非常强大的芯片开发能力,并且结合自己对业务线的理解,能够定义出效率更高的产品。”耀途资本执行董事于光日前对澎湃科技(www.thepaper.cn)评价说。至于英伟达的追赶者AMD也是一个大玩家,AMD作为一个老牌的CPU和GPU厂商,过去在服务器CPU领域形成了追赶反超,如今发力AI芯片,是英伟达较为强劲的竞争对手之一。

也有科技投资人对澎湃科技表示,英特尔在AI芯片方面也一直落后于英伟达。

英特尔2019年以来一直在制造Gaudi芯片,去年12月在“AI无处不在”(AI Everywhere)发布会上发布了Gaudi3芯片。但罗森布拉特证券分析师汉斯·莫塞曼(Hans Mosesmann)表示,“除了英特尔,AI似乎无处不在。”英国投资服务机构AJ Bell投资总监拉斯·莫尔德(Russ Mould)则表示,随着英伟达和AMD等公司的芯片在AI行业发挥越来越重要的作用,英特尔有被甩在后面的危险。

“英伟达的技术、产品和业务处于竞争最为激烈的领域,其特点是技术变革迅速和行业标准不断发展。”深圳中欧基金投资有限公司(即“中欧资本”)董事长张俊对澎湃科技(www.thepaper.cn)表示,未来竞争将更加激烈,竞争来自现有竞争对手和新市场进入者。尤其是新进入者,也是潜在颠覆者。

与其等待大公司犯错,不如创新

英伟达的AI芯片已经成为硬通货。

于光表示,英伟达在AI芯片上的布局深厚,产品适配灵活。“上一波AI浪潮中,出现了各种创新架构的AI芯片玩家,试图颠覆英伟达,但是都没有取得很广泛的成功。最后还是英伟达最先赶上了大模型这波机会。”从这一波浪潮来看,已经有很多玩家希望去做针对当前大模型更加优化的AI芯片,但要说颠覆,依然很难。目前来看,AI企业还无法摆脱英伟达这个角色,“基本上还得依赖英伟达的GPU芯片乃至整体解决方案。”

“从来没有哪一个领域的芯片有今天AI芯片这么大的市场,大到夸张。”国产GPU行业资深人士薛翔告诉澎湃科技(www.thepaper.cn),“芯片行业有一个说法,一个领域的芯片,只能有两家公司活得很好,第一家占80%市场份额,第二家占20%。”

过去,英特尔的CPU市场大,但单价低;而英伟达H100芯片单价超过了20万元人民币。特斯拉CEO马斯克曾透露,特斯拉今年仅在英伟达AI芯片上就要花5亿美元。这看似是一笔巨款,但实际上只相当于大约1万块H100。“很多公司发现,一年买10万张英伟达的加速卡,成本一点也不划算,不如养一个团队自己研发。”薛翔说,这是一个商业选择。

正如Meta斥资数十亿美元购买英伟达和其他公司的人工智能芯片,面对不断膨胀的算力需求,Meta走上自研之路,减少对英伟达的依赖,降低成本。ChatGPT之父、OpenAI首席执行官山姆·奥特曼也在拉拢中东投资者和芯片制造商,欲筹数十亿美元建芯片公司,构建半导体工厂网络。日本软银集团创始人兼首席执行官孙正义则计划为AI芯片企业筹资1000亿美元,与英伟达竞争。

科技巨头的容错能力强,每一次科技领域的革命并不源于大公司犯错,而是源于一项新兴技术的快速崛起。“老公司的退潮和新公司的崛起都是时代变化所致。”薛翔说,在芯片领域,也许未来会出现适用于大模型的更专用的芯片,而带来这一革命的也许是一家没有历史包袱的新兴公司。所以,与其等待大公司犯错,不如自我创新。

但于光认为,在国外的芯片创新生态里,创业公司很难颠覆芯片巨头。不同于大模型的快速迭代,AI芯片开发周期长,人力、物力投入大。“创业型AI芯片公司可以通过芯片架构的创新获得融资,然后迭代出前面几代产品,最后的路径有可能还是被那些大厂收购,因为真正到工程量产和商业化阶段,大厂更有优势。”

开发AI芯片不能仅盯算力性能

以大模型为代表的人工智能技术突飞猛进,算力需求激增,升级芯片成为必然。薛翔表示,英伟达等国外科技大厂自A100芯片后“刹不住车”,开发的芯片“一代更比一代强”,性能遥遥领先。“现在相当于在直道上开赛车,芯片生产技术和集群技术没有达到物理瓶颈之前,沿着这条路往前面跑可以跑得很快,两三代产品迭代以后会带来非常大的差距。”但薛翔表示,这是正常现象,不需要过于担忧。

目前GPU的存储性能和算力共同决定了大模型的推理速度。但薛翔表示,当前大模型的使用场景对模型生成速度要求并没有那么高。所以用AI芯片做单卡大模型推理时,瓶颈主要在存储。

于光表示,前几年的AI浪潮中,谷歌、Meta等科技巨头根据自身业务需求自研AI定制芯片。如今大模型带来AI迅速变革,这些玩家如何将AI芯片适配当前的大模型算法是共同面对的话题。他同样认为,开发AI芯片不能仅仅盯着算力性能,存储和互联是AI芯片需要解决的问题。

一方面,大模型参数多,需要大容量的存储空间,目前看起来需要塞下这么大的模型必须要用到HBM(一款新型的CPU/GPU内存芯片)。另一方面,数据需要从HBM高速传递给GPU的计算die(没有封装的裸片), GPU之间需要高速互联例如NVLink(英伟达开发并推出的一种总线及其通信协议)和NVSwitch(英伟达的一种高速交换机技术)来实现高速通信,以及需要更上层的高速组网方式形成计算集群。于光表示。

再者,在薛翔看来,无限制堆参数和芯片更应该是一种科研行为而非应用行为,“那么大的模型运行一次很贵,并不符合商业逻辑。”反观当下,“有一个概念叫AI Infra(人工智能基础设施),基于现有大模型优化硬件和模型,目的是提高效率。”薛翔估计,“优化算力使用效率,优化模型结构,不用堆那么多参数,如果每一个方面都能节省20%,整体可以节省50%多的成本。”

深圳元始智能有限公司(即“RWKV元始智能”)首席运营官罗璇对澎湃科技(www.thepaper.cn)表示,中国大部分模型基于低计算效率的开源模型进行微调或重训练,大部分模型类似于Meta的LLaMA2模型。这是一个基于Transformer架构的大语言模型,从第一性原理角度看,Transformer复杂度过高,算力需求大,未来多智能体、具身智能、世界模型的开发将受限于计算复杂度。这也导致大模型企业被英伟达的GPU“卡脖子”,另一方面英伟达芯片以10倍定价出售,“这是一个非常不正常的算力成本。”

Transformer架构和芯片卡住了大模型商业落地和前端研究,罗璇认为一定要找到新的架构,企业才能跑出PMF(产品市场匹配度)。另一方面,“一定不要买高溢价的算力,大部分的钱是被英伟达赚走的。我们认为接下来会有新的算力把成本打到现在的1/10甚至1%。”站在芯片使用者的角度,罗璇表示,目前国产算力还不够便宜,如何把训练和推理成本降下来,是国产芯片要解决的问题。